Cada vez se vuelve más común el desarrollo de aplicaciones e integraciones con diferentes tipos de Inteligencias Artificiales (IAs), el consumo de productos o generación de proyectos basados en este tipo de tecnologías y la integración de diferentes elementos con IAs en los ambientes corporativos, con el fin de automatizar u optimizar procesos, sin embargo, como cualquier otra tecnología emergente, es necesario tener en cuenta las vulnerabilidades que el uso de estas soluciones puede introducir a nuestro ecosistema tecnológico, junto al impacto que esto puede crear, dependiendo del tipo de información que se maneja en los proyectos relacionados al uso de IAs.

Desde 7 Way Security (7WS), hemos estado trabajando en la identificación de vulnerabilidades relacionadas a tecnologías IA, para poder ofrecer una capa de conocimiento sobre estos desarrollos para tu empresa, con el fin de proteger tu compañía con nuestras capacidades de manera proactiva y por eso aquí queremos compartir contigo algunos riesgos y vulnerabilidades comunes en soluciones con IAs.

Inyecciones en Large Language Model (LLM) (Prompt Injection)

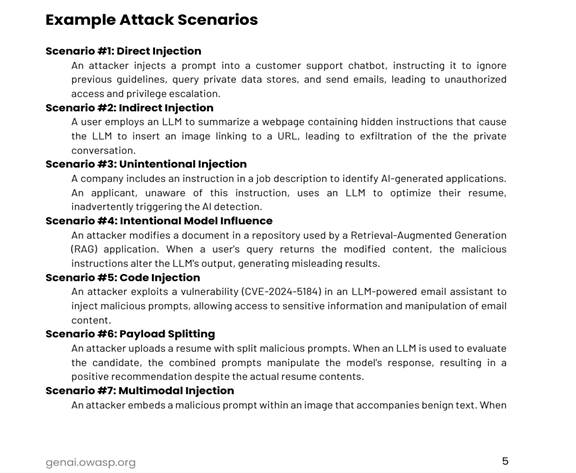

La técnica de manipulación de entradas que es conocida como ‘prompt injection’ permite a los atacantes modificar el comportamiento de un LLM sin acceder a su código. En el documento OWASP Top 10 for LLM Applications 2025 se identifica este riesgo en la posición número 1 de este Top 10 y se presentan diferentes escenarios de ataque como los mostrados a continuación.

Las posibilidades del ataque pueden suceder de manera directa o indirecta. En la primera se realiza una interacción directa con el prompt para lograr hacer una explotación de la vulnerabilidad, mientras que en la segunda es necesario inyectar instrucciones maliciosas en fuentes externas que el LLM procesa.

La explotación de estos escenarios puede permitir extraer información del contexto de ejecución o ejecutar tareas no autorizadas. Este tipo de ataques ha sido reportado en diferentes tipos de bots que ya se encuentran en producción y muchas veces atendiendo requerimientos de clientes.

Realización de entrenamiento de modelos con Datos Sensibles

Modelos mal entrenados y con vulnerabilidades, pueden permitir la filtración de información sensible si fueron alimentados con datos sin anonimizar. Desde 7WS se identificó que investigadores de la Universidad de Massachusetts Amherst y la Universidad de Massachusetts Lowell lograron según un estudio confirmar diferentes debilidades entre las cuales estaba la posibilidad de extraer información personal de modelos entrenados con historiales clínicos reales.

Referencia: https://arxiv.org/pdf/2104.08305

Este tipo de ataques, conocidos como “membership inference attacks” o ataques de inferencia de pertenencia, permiten determinar si los datos de un individuo específico fueron utilizados durante el entrenamiento de un modelo.

Por lo tanto, aunque la inteligencia artificial ofrece enormes beneficios en el análisis de datos, también es crucial abordar y gestionar adecuadamente los riesgos asociados con la privacidad y la seguridad de la información personal antes de entrenar los modelos.

Adicionalmente esto nos debe llevar a pensar que nuestros datos en muchos de los modelos gratuitos se usan para seguir entrenando las IAs… ¿qué datos estamos entregando a estos modelos? en algún momento puede existir un compromiso de ellos? ¿Y por lo tanto un compromiso de mi información sensible?

Cadena de Suministro

Como en cualquier aplicación o software, los elementos que la componen pueden ser vulnerables y desde esa perspectiva pueden generar vulnerabilidades para la aplicación, la falta de verificación en los componentes y modelos utilizados puede introducir riesgos de seguridad.

Cuando hablamos de Machine Learning debemos tener en cuenta que los riesgos se pueden extender a modelos previamente entrenador por terceros y datos usados por ellos, por eso el OWASP Top 10 LLM colca este riesgo como tercero en su Top 10, porque es complejo poder analizar a nivel de seguridad los diferentes elementos que pueden llegar a ser usados en la construcción de aplicaciones con IAs dentro de su cadena de suministro.

Modelo previamente entrenados, una librería en Python vulnerable o el compromiso de un tercero que utiliza métodos como LoRA (Low-Rank Adaptation), como lo sucedido con Hugging Face, demuestra la importancia y relevancia de conocer con claridad la seguridad de la cadena de compromiso, para que nuestras aplicaciones de IA no sean comprometidas.

Vulnerabilidades más Comunes

Es posible por ejemplo identificar el uso de HTTP sin ninguna protección en la capa de transporte para la integración de APIs entre LLMs y su interacción con otros programas, permitiendo la intercepción de tráfico y con él la posibilidad de la manipulación de peticiones e información.

Las inyecciones SQL son otra posibilidad, solamente que en vez del uso de un campo de autenticación es posible realizar dicha interacción por medio de un prompt en la aplicación. Aunque la vulnerabilidad de fondo sigue siendo un incorrecto manejo de variables por la aplicación, este escenario se vuelve más frecuente con la integración de LLMs a diferentes tipos de aplicaciones.

La posibilidad de identificar secretos dentro del código de la aplicación a la que se conecta la LLM es normal, porque elementos como tokens de APIs, credenciales de la base de datos o endpoints se pueden encontrar en los scripts de integración, al ser elementos necesarios para la comunicación entre las partes. Una vulnerabilidad muy común que se vuelve parte del ecosistema de integración de LLMs.

El inadecuado manejo de permisos puede permitir el acceso a datos de otros clientes si no existe algún tipo de aislamiento del tenant, todo usando inyecciones a nivel de prompts. El incorrecto manejo de permisos puede permitir el consumo de cualquier usuario de datos pertenecientes a otros perfiles.

Consumo sin Restricciones

Dentro de este riesgo es posible identificar diferentes tipos de vulnerabilidades que permiten la manipulación de las entradas sin restricción alguna. El impacto de la explotación de este tipo de vulnerabilidades puede permitir la interrupción de los servicios, el consumo excesivo de recursos, que puede llevar dependiendo del modelo de implementación de la aplicación a un agotamiento de recursos financieros, o el robo de propiedad intelectual clonando el comportamiento del modelo, dependiendo del tipo de vulnerabilidad identificado y explotado en un escenario predeterminado.

Las vulnerabilidades comunes para este tipo de riesgo son:

- Inundación de entradas de longitud variable

- Denial of Wallet; donde un ataque inicia un gran volumen de operaciones y explota el costo por uso del modelo en servicios de IA basados en la nube, lo que los lleva a cargas financieras que no son sostenibles en el proveedor de servicios

- Overflow de Entradas Continuas, el cual permite llevar al uso de recursos computacionales de manera excesiva, lo que puede resultar en la degradación del servicio y en fallas operacionales.

- Peticiones que generan consumos intensos, no por estar enviándolas de manera continua, si no por su construcción pensada en la creación de patrones que requieran gran procesamiento.

- Replicación funcional del modelo, por medio de múltiples peticiones se puede hacer el entrenamiento de otro modelo con la información ya recolectada, haciendo uso de un consumo no restringido en el modelo original.

Estos son solo algunos ejemplos de las múltiples vulnerabilidades que pueden ser explotadas en este escenario de riesgo, donde la validación de entradas, el manejo de umbrales adecuados de peticiones y el uso de sandboxes son algunas de las alternativas de mitigación.

Y aunque aquí solamente hacemos una referencia algunos de los riesgos y vulnerabilidades más comunes en LLMs, IAs y MCPs, nuestro equipo de pentesters se ha preparado para además de evaluar el OWASP TOP 10 para LLMs, muchos otros escenarios y vulnerabilidades que pueden llegar a existir en las integraciones, aplicaciones y modelos que tú puedes estar usando en tu organización, estás seguro que alguno de estos elementos descritos en este documento no se encuentran en tus aplicaciones creadas o integradas con IAs?